最大似然估计(Maximum Likelihood Estimation) - 机器学习基础

本文共 1105 字,大约阅读时间需要 3 分钟。

内容总结自自花书《deep learning》Chapter 5.5,由英文版翻译而来。英文版官网可以免费查阅:

评估器(estimators)从何而来?相较于猜测某个函数可能产生一个好的估计器,然后再分析其偏差和方差,我们更愿意拥有一些原则,可以用来推导针对不同模型的好的估计器的特定函数。

最常用的这种原则就是最大似然原则(maximum likelihood principle)。

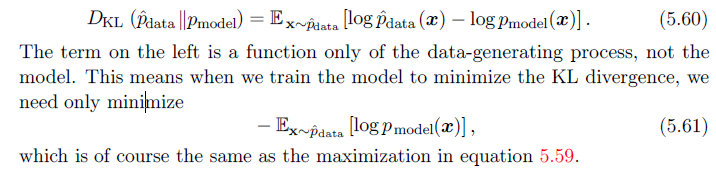

一种对最大似然估计的解释是将其看做是对模型的分布和训练集所定义的实验分布 p ^ d a t a \hat{p}_{data} p^data的差异的最小化。差异的程度使用Kl散度来衡量。

一种对最大似然估计的解释是将其看做是对模型的分布和训练集所定义的实验分布 p ^ d a t a \hat{p}_{data} p^data的差异的最小化。差异的程度使用Kl散度来衡量。  最小化KL散度恰恰对应于最小化分布之间的交叉熵。很多作者会对伯努利分布和softmax分布的负log似然使用交叉熵这个术语,这实际上是错误使用。任何包含负log似然的loss函数都是训练集定义的实验分布和模型定义的概率分布的交叉熵。例如,MSE是实验分布和高斯模型的交叉熵(原书前面有详细推导过程,证明了最小化高斯模型的交叉熵和最小化MSE是一致的,5.5.1也有一个类型的推导过程。)。

最小化KL散度恰恰对应于最小化分布之间的交叉熵。很多作者会对伯努利分布和softmax分布的负log似然使用交叉熵这个术语,这实际上是错误使用。任何包含负log似然的loss函数都是训练集定义的实验分布和模型定义的概率分布的交叉熵。例如,MSE是实验分布和高斯模型的交叉熵(原书前面有详细推导过程,证明了最小化高斯模型的交叉熵和最小化MSE是一致的,5.5.1也有一个类型的推导过程。)。 这样我就得到了不管是最大化似然还是最小化KL散度都是在得到最优的 θ \pmb{\theta} θθθ。最大似然这样就变成了最小化负log似然(NLL),或者等价的,交叉熵的最小化。把最大似然看作是KL散度的最小化是非常有帮助的,因为KL散度有一个已知的最小值0,而负log似然实际上在 x \pmb{x} xxx是实数值时可以是负的。

最大似然的性质

最大似然主要的吸引力在于它可以被证明是最好的估计器逼近,当样本数量m趋近于无穷时,它收敛的比率随着m增大而增大。

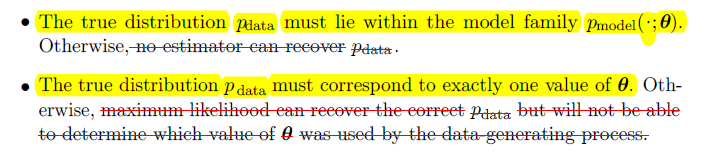

在以下两个条件下,最大似然估计器具有一致性(consistency)的性质:

然而,具备一致性的估计器在统计效率(statistical efficiency)上可以是不同的,这意味着一个一致估计器在固定数量上的m样本上可以取得低泛化误差(generalizarion error),或者等价地说,只需要更少的样本就足以取得固定水平的泛化误差。

然而,具备一致性的估计器在统计效率(statistical efficiency)上可以是不同的,这意味着一个一致估计器在固定数量上的m样本上可以取得低泛化误差(generalizarion error),或者等价地说,只需要更少的样本就足以取得固定水平的泛化误差。 统计效率通常在在有参(parametric case)情况下被研究。

Cramér-Rao lower bound (Rao, 1945; Cramér, 1946)证明了没有其他的一致性估计器能比最大似然估计器取得更低的MSE。

因为一致性和高效性,最大似然通常是使用机器学习的首选估计器。当样本数量足够小以至于会产生过拟合时,可以采用诸如权重衰减等正则策略来得到一个具有更小方差的最大似然的有偏版本,尤其是在训练数据受限时。

转载地址:http://hsvpi.baihongyu.com/

你可能感兴趣的文章

vue 项目中图片选择路径位置static 或 assets区别

查看>>

vue项目打包后无法运行报错空白页面

查看>>

Vue 解决部署到服务器后或者build之后Element UI图标不显示问题(404错误)

查看>>

element-ui全局自定义主题

查看>>

facebook库runtime.js

查看>>

vue2.* 中 使用socket.io

查看>>

openlayers安装引用

查看>>

js报错显示subString/subStr is not a function

查看>>

高德地图js API实现鼠标悬浮于点标记时弹出信息窗体显示详情,点击点标记放大地图操作

查看>>

初始化VUE项目报错

查看>>

vue项目使用安装sass

查看>>

HTTP和HttpServletRequest 要点

查看>>

在osg场景中使用GLSL语言——一个例子

查看>>

关于无线PCB中 中50欧姆的特性阻抗的注意事项

查看>>

Spring的单例模式源码小窥

查看>>

后台服务的变慢排查思路(轻量级应用服务器中测试)

查看>>

MySQL中InnoDB事务的默认隔离级别测试

查看>>

微服务的注册与发现

查看>>

bash: service: command not found

查看>>

linux Crontab 使用 --定时任务

查看>>